文:文盲诗仁

(资料图)

(资料图)

编辑:文盲诗仁

深度学习在计算机视觉领域取得了巨大的突破,尤其是在自动图像生成和编辑方面。

自动图像生成和编辑技术利用深度学习模型学习图像的特征和结构,可以生成逼真的图像、修改图像内容、实现图像风格转换等。

这些技术在艺术创作、娱乐产业、设计和广告等领域具有广泛的应用前景。

目前深度学习已成为自动图像生成和编辑技术的主要方法之一。

其中,生成对抗网络(GANs)是一种常用的模型架构,它由生成器和判别器组成,通过对抗学习的方式生成逼真的图像。

此外,变分自编码器(VAEs)和自注意力机制(self-attention)等方法也被广泛应用于图像生成和编辑任务。

深度学习在自动图像生成和编辑领域的优势和难题

深度学习在自动图像生成和编辑领域的优势:

逼真的图像生成:基于深度学习的自动图像生成技术可以生成逼真的图像,具有高度的细节和真实感,使得生成的图像在视觉上难以与真实图像区分。

多样性的图像生成:通过引入随机向量作为输入,生成对抗网络(GANs)可以生成多样性的图像样本,使得生成的图像不仅逼真,而且具有一定的变化和多样性。

图像编辑的灵活性:深度学习模型可以学习到图像的特征表示,使得对图像进行编辑操作变得灵活和可控,可以通过修改输入向量或引入额外的约束来实现对图像内容和风格的编辑。

深度学习在自动图像生成和编辑领域的难题:

训练复杂度:基于深度学习的自动图像生成和编辑技术需要大量的训练数据和计算资源。训练深度神经网络需要耗费大量的时间和计算资源,并且需要解决梯度消失、过拟合等问题。

模型稳定性:生成对抗网络(GANs)的训练过程中存在模式崩溃和不稳定性的问题,为了解决这些问题,研究人员提出了许多改进的GANs变体,如Wasserstein GAN、条件GAN等。

控制生成结果:在某些应用场景下,需要对生成结果进行精细的控制,以满足特定的需求。然而,目前对于生成结果的精细控制仍然是一个难题,需要进一步研究如何调整生成模型以达到更好的可控性。

为了克服这些难题,研究人员提出了许多改进和优化的方法,例如,可以使用条件生成对抗网络(cGANs)来实现对生成结果的精细控制。

引入注意力机制和变分自编码器(VAEs)来提高图像生成的质量和多样性,采用迁移学习和预训练模型来加速训练和提高生成效果等。

此外,还可以结合其他领域的知识,如计算机图形学、图像处理等,来进一步提升自动图像生成和编辑的技术。

基于深度学习自动图像生成的方法及应用

自动图像生成的方法

生成器网络接受一个随机向量作为输入,通过一系列的卷积、反卷积和激活函数操作逐渐生成图像。

判别器网络用于判断生成的图像与真实图像的区别,并提供反馈信号以改善生成器的输出,通过不断迭代训练生成器和判别器,GANs可以生成具有逼真细节和多样性的图像。

在图像编辑任务中,深度学习模型可以通过学习图像的特征表示来实现内容修改、风格转换等操作。

例如,使用卷积神经网络可以提取图像的语义信息,然后通过图像编辑技术修改特定物体的外观或位置。

另外,通过训练神经网络学习不同风格的图像表示,可以实现图像风格转换,将一幅图像的风格迁移到另一幅图像上。

自动图像生成的应用

在艺术创作领域,艺术家可以利用这些技术生成艺术作品、探索创造力的边界,在娱乐产业中,这些技术可以用于游戏中的场景生成、角色设计和特效制作,在设计和广告领域,这些技术可以帮助设计师和广告人员快速生成、修改和定制图像素材。

深度学习的自动图像生成和编辑技术基于神经网络模型,其中最常用的模型是生成对抗网络GANs。

GANs由生成器网络和判别器网络组成,通过对抗训练的方式实现图像生成和编辑。

生成器网络负责生成逼真的图像样本,而判别器网络则负责判断输入的图像是真实的还是生成的,通过交替训练生成器和判别器,GANs可以逐渐提升生成器的能力,使其生成的图像与真实图像更加接近。

下面是一个简化的代码示例,演示了如何使用PyTorch实现基于GANs的图像生成

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

from torch.autograd.variable import Variable

#定义生成器网络

class Generator(nn.Module):

def_ _init_ _ (self, latent dim, image_dim):

super(Generator,self)._init_()

self.model=nn.Sequential(

nn.Linear(latent_dim,128),

nn.LeakyReLU(0.2),

nn.Linear(128,image_dim),

nn.Tanh()

# 定义生成器网络

class Generator(nn.Module):

def __init__(self, latent_dim, image_dim):

super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Linear(latent_dim, 128),

nn.LeakyReLU(0.2),

nn.Linear(128, image_dim),

nn.Tanh()

)

def forward(self, x):

return self.model(x)

# 定义判别器网络

class Discriminator(nn.Module):

def __init__(self,image_dim):

super(Discriminator,self).init_()

self.model=nn.Sequential(

nn.Linear(image_dim,128),

nn.LeakyReLU(0.2),

nn.Linear(128,1),

nn.Sigmoid()

)

def forward(self,x):

return self. model(x)

defforwardself x:

return self.model(x)

# 定义训练函数

def train(generator, discriminator, dataloader, num_epochs, latent_dim,

criterion=nn.BCELoss()

optimizer_g=optim.Adam(generator.parameters(),1r-0.001)

optimizerd=optim.Adam(discriminator.parameters(().1r=0.001)

for epoch in range(num_epochs):

for batch idx,(real images,)in enumerate(dataloader):

batch size=real images.size(O)

real images=real images.view(batch size-1).to(device)

real labels=torch.ones(batchsize1).to(device)

fake labels = torch.zeros(batch size).to (device)

# 训练判别器

optimizer_d.zero_grad()

z=Variable(torch.randn(batch sizelatentdim)).to(device)

fake images=generator(z)

real preds=discriminator(realimages)

fake preds=discriminator(fakeimages)

d loss=criterion(real preds,real labels)+ criterion(fake

d_loss.backward()

optimizer_d.step()

# 训练生成器

optimizer_g.zero_grad()

z=Variable(torch.randn(batch size,latentdim)).to(device)

fake images=generator(z)

fake_preds=discriminator(fake_images)

g loss=criterion(fake_predsreal labels)

g_loss.backward()

optimizer g . step()

# 设置训练参数

latent_dim = 100

image_dim =784

batch_size =64

num_epochs =10

device=torch.device(cuda’if torch.cuda.is_available() else "cpu")

# 加载MNIST数据集

transform=transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,),(0.5,))

])

dataset =datasets.MNIST(root="./data’.train=True.transform=transform

dataloader=DataLoader(dataset,batch_size=batch_size, shuffle=True)

#创建生成器和判别器实例

generator=Generator(latent_dim,image_dim).to(device)

discriminator = Discriminator(image dim).to(device)

深度学习框架中常用的工具

TensorFlow:这是广泛使用的深度学习框架,提供了丰富的图像处理和模型训练工具。它支持卷积神经网络、生成对抗网络等模型的实现和训练。

PyTorch:提供了灵活的张量操作和自动求导功能,PyTorch可以用于构建和训练生成器和判别器网络,并支持图像生成和编辑任务。

Keras:这是一个高级神经网络库,可以在多个深度学习框架上运行,包括TensorFlow和Theano。Keras提供了简化的接口和模块化的结构,适合快速实现和测试图像生成和编辑模型。

OpenCV:广泛应用于计算机视觉任务的开源库,提供了丰富的图像处理和分析功能,OpenCV可以与深度学习框架集成,用于预处理图像数据、可视化结果和评估模型性能。

下面是一个示例代码,演示了使用Keras和TensorFlow实现图像生成的过程

importtensorflowastf

from tensorflow import keras

from tensorflow.keras import layers

#定义生成器模型

def build generator(latent_dim):

model=keras.Sequential()

model.add(layers.Dense(7*7*256,inputdim=latent dim))

model.add(layers.Reshape((7,7,256)))

model.add(layers.Conv2DTranspose(128kernel size=4. strides=2

model.add(layers.BatchNormalization())

model.add(layers.LeakyReLU(alpha=0.01))

model.add(lavers.Conv2DTranspose(64. kernel_size=4. strides=2

model.add(layers.BatchNormalization())

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Conv2DTranspose(1,kernel_size=7, strides=1,

return model

#设置训练参数

latent_dim =100

batch_size =64

epochs =50

#加载MNIST数据集

(x_train,_),(_,_)=keras.datasets.mnist.load_data()

x_train =x_train.reshape(-1,28,28, 1).astype("float32")

x_train =(x_train - 127.5) / 127.5

# 创建生成器、判别器和生成对抗网络实例

generator=build generator(latentdim)

discriminator=build discriminator)

gan =build_gan(generator,discriminator)

#定义损失函数和优化器

crossentropy=keraslosses.BinaryCrossentropy(from_logits=True)

generator_optimizer =keras.optimizers.Adam(learning_rate=0.0002. beta_1=0.5

discriminator optimizer keras optimizers Adam(learning rate0.0002,beta1)

#定义判别器模型

def build discriminator():

model=keras.Sequential()

model.add(layers.Conv2D(64,kernel_size=3,strides=2,padding="same", i

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Conv2D(128,kernel_size=3, strides=2, padding="same"))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Flatten(())

model.add(layers.Dense(1,activation="sigmoid"))

return model

#定义生成对抗网络模型

def build gan(generator, discriminator):

discriminator. trainable= False

# 定义训练循环

@tf.function

def train_step(images):

noise =tf.random.normal([batch_size,latent_dim])

with tf.GradientTape() as gentape, tf.GradientTape() as disc tape:

generated_images=generator(noise,training=True)

real output=discriminatorimagestraining=True)

fake output=discriminator(generatedimagestraining=True)

gen_loss=generator_loss(fake_output)

disc_loss=discriminator loss(real_output,fakeoutput)

# 开始训练

def train(dataset, epochs):

for epoch in range(epochs):

for image_batch in dataset:

train step(image batch)

#include<iostream

#include <Poco/Net/ServerSocket.h>

#include <Poco/Net/HTTPRequest.h>

#include <Poco/Net/HTTPResponse.h>

#include <Poco/Net/HTTPServerRequest.h>

#include <Poco/Net/HTTPServerResponse.h>

#include <Poco/Net/HTTPServer.h>

#include <Poco/Util/ServerApplication.h>

using namespace Poco;

using namespace

Poco::Net;

using namespace Poco::Util;

class MyRequestHandler : public HTTPRequestHandler {

public:

void handleRequest(HTTPServerRequest& request,HTTPServerResponse&

std::ostream& responseBody=response.send();

class MyRequestHandler :public HTTPRequestHandler{

public:

void handleRequest(HTTPServerRequest& request,HTTPServerResponse&

std::ostream& responseBody=response.send();

response.setStatus(HTTPResponse::HTTP_0K);

response.setContentType("text/html");

responseBody << "<html>";

responseBody << "<body>";

responseBody << "<h1>Hello,World!</h1>";

responseBody << "</body>";

responseBody<< "</html";

intmain) {

boost::asio::io_context io_context;

boost::asio::ip::tcp::acceptor acceptor(io_context,boost::asio::ip

while(true){

boost::asio::ip::tcp: socket socket(io_context):

acceptor.accept(socket);

// 处理每个连接的请求

handle_request(socket);

}

return0;

以上是一个基于Keras和TensorFlow的简单生成对抗网络(GAN)模型的实现代码。

这段代码定义了生成器、判别器和生成对抗网络模型,并使用MNIST数据集进行训练。

在训练循环中,通过计算生成器和判别器的损失函数,并使用优化器进行梯度更新,来不断优化模型。

结论

基于深度学习的自动图像生成和编辑技术在自然图像合成、图像风格转换和图像内容修改等任务中取得了显著的进展。

随着深度学习模型的不断演进和算法的改进,这些技术在未来将继续发展,并在各个领域带来更多的应用和创新。

然而,仍然存在一些难题,如模型的稳定性、生成图像的多样性和可控性等方面,需要进一步研究和改进。

检察官担任法治副校长有了“指挥棒”

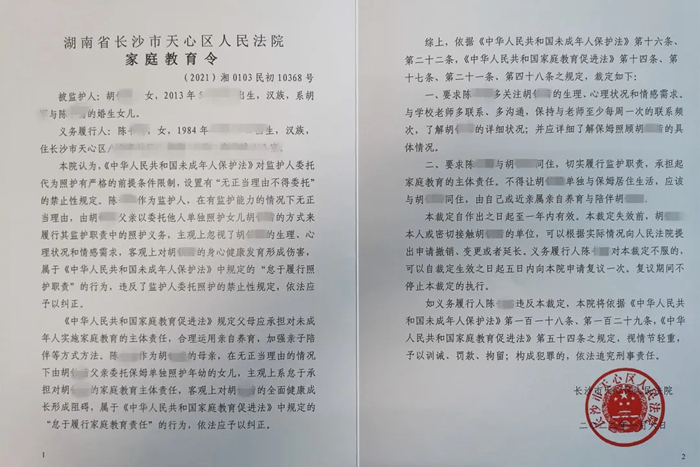

检察官担任法治副校长有了“指挥棒” 全国首份《家庭教育令》来了!督促家长“依法带娃”

全国首份《家庭教育令》来了!督促家长“依法带娃” 俄军装甲车辆将具备隐身能力

俄军装甲车辆将具备隐身能力